Wer sich um KI – Künstliche Intelligenz – interessiert, wird bemerkt haben, wie sich die Anzahl Artikel in den Medien über das Thema in den letzten Monaten vervielfacht hat. Früher war es für Nerds und Wissenschaftler von Interesse, heute scheinen sich auch grössere Kreise dafür zu interessieren.

Doch leider nur scheinbar, denn eine fundierte Diskussion findet in der Breite nicht statt. Was insofern schade ist, weil «Künstliche Intelligenz» eine ungebremste, ungeahnte und folgenreiche Revolution in der Arbeits-, Wissenschafts- und Gesellschaftswelt bedeutet. Und ohne den Schwarzen Peter an die Wand malen zu wollen: Ohne Gefahren und Opfer wird diese Revolution nicht ablaufen.

«Digitalisierung», «Automatisierung» und «Künstliche Intelligenz» sind Synonyme für die Verwandlung westlicher Industrie- und Dienstleistungsgesellschaften. Dass es manchmal auch unterhaltsame Kapitel – wie der spannende Kampf zwischen einem Hacker («Est-Ee Security») und Google «reCaptcha v2» – gibt, steht ausser Frage. Wer aber die grundlegende KI-Diskussion weiterführt und die sich eröffnenden Möglichkeiten selbstlernender Systeme weiterdenkt, wird Hühnerhaut kriegen.

«Künstliche Intelligenz» bedeutet, dass Maschinen (im engeren Sinne: Software) lernen, sich anhand von Datenstämmen selbstständig weiterzuentwickeln, um die – im Sinne des Programmierers – benötigten Funktionen und Analysen besser, schneller und präziser auszuführen bzw. durchzuführen. Genau «da» aber liegt der Hund begraben: Denn der Datenstamm* (die Basis der zugrunde liegenden Daten) kann willkürlich, nicht öffentlich zugänglich, rassistisch eingefärbt oder für die Ausgangslage falsch sein – hinzu kommen alle Möglichkeiten von falschen Annahmen oder schlicht falschen Algorithmen, die die Daten – auch wenn diese richtig wären – falsch auslegen. So schaffte es Google** teilweise nicht, der Bilderkennungssoftware beizubringen, dass schwarze Menschen keine Gorillas sind. Was sich so einfach liest, kann in einer hochgradig automatisierten Welt zum Verhängnis für ganze Menschengruppen oder auch Individuen ausarten. Die Bezeichnung zum «Gorilla» ist dabei noch das kleinste aller möglichen Übel.

Dass hier ein «worst case»-Szenario skizziert wird, ist klar. Aber wer weiss schon detailliert, mit welchen Daten «Deep Mind», «Watson» (die «Künstliche Intelligenz» von IBM), «Aura» (die vierte Plattform neben dem Kernnetz, den IT-Systemen und den Produkten und Dienstleistungen der Telefonica) oder alle Google-, Facebook- und Apple-Systeme arbeiten – um nur ein paar wenige zu nennen.

Revolutionen – so erzählt man sich – fressen ihre Kinder.

Wir sollten vorsichtig sein.

* Beispiel von Datenstämmen

Nehmen wir dazu als Ausgangslage das Gedankenexperiment von Klaus Mainzer aus dem Buch «Künstliche Intelligenz – Wann übernehmen die Maschinen?».

- Wenn ein Auto oder ein Lastwagen von der Strasse abkommt, dann ist der Fahrer häufig eingeschlafen.

- Das Fahrzeug ist von der Strasse abgekommen.

Nun ist (1) eine genügende Bedingung für (2), aber gleichzeitig ist (1) nicht die einzige Möglichkeit für (2). Oder in einfachen Worten: Nicht bei allen Autos oder Lastwagen, die von der Strasse abgekommen sind, waren die Fahrer eingeschlafen. Das aber benötigt jedoch ein umfangreiches (und unvoreingenommenes) Expertenwissen.

Bei einer vorwärtsgerichteten Fragestellung fragt man das «KI-System»: «Was sind die häufigsten Ursachen, wenn ein Fahrzeug von der Strasse abkommt?» – Antwort «KI»: «Fahrer, die einschlafen.»

Ist die Fragestellung jedoch rückwärtsgerichtet fragt man: «Warum ist das Auto von der Strasse abgekommen?» – Antwort «KI»: «Der Fahrer ist vermutlich eingeschlafen.»

Nun wissen wir, dass dies oft nicht stimmen muss: Es gibt tausend andere Möglichkeiten, warum ein Fahrzeug von der Strasse abkommen könnte. Wenn aber der Datenstamm des «KI-Systems» nur Unfälle statistisch erfasst hat, welche den Punkten (1) und (2) entsprechen, werden seine Antworten eindeutig sein. Das Problem ist, dass in diesem Fall die Trainingsdaten des «KI-Systems» mit Vorurteilen oder mit gewieften Geschäftsinteressen «verunreinigt» sind.

Lächerlich? Ja, vielleicht, aber dennoch nicht von der Welt zu weisen:

- http://www.krone.at/digital/kuenstliche-intelligenz-ist-traum-der-faschisten-microsoft-expertin-story-559108

- http://www.zeit.de/digital/internet/2016-05/kuenstliche-intelligenz-republica-ethik-kate-crawford.

** Meine Freundin ist kein Gorilla.

Obwohl es sich offenbar um einen «Einzelfall» handeln könnte, ist das Ausmass in einer digitalisierten Welt potenziell beängstigend. Wenn keine Menschen (mehr) gewisse Analysen und Schlussfolgerungen von KI-Systemen überprüfen, könnte es für Einzelne oder Gruppen gefährlich werden.

Das Fraunehofer Institut

Solange der Datenstamm oder die Trainingsdaten eines «KI-Systems» nicht offengelegt werden, bleiben die Entscheidungen der Software immer eine Blackbox. Dem möchte das Frauenhofer Institut entgegenwirken. Am Institut wurde eine Software entwickelt, die, ausgehend von den Analysen/Entscheidungen eines «KI-Systems», die möglichen Entscheidungsprozesse aufzeigt: http://winfuture.mobi/news/96603

Bemerkung

Ich habe die Beispiele im Artikel bewusst stark vereinfacht. Weiter schreibe ich von KI-Systemen und meine damit alle KI-Technologien, die per heute im weitesten Sinne dazugehören.

Buchempfehlung

Das Buch «Künstliche Intelligenz – Wann übernehmen die Maschinen» von Klaus Mainzer (http://www.springer.com/de/book/9783662484524) geht dem Thema fundiert nach und erklärt die verschiedenen Formen künstlicher Intelligenz. Das Buch fordert an gewissen Stellen und in einigen Kapiteln eine ordentliche Portion abstraktes Vorstellungsvermögen. Dennoch: Lesenswert.

«Vorsichtig» sein reicht nicht. «Rumpelstilzchen» sagt uns, was wirklich hilft: Das Böse bei seinem Namen zu nennen – dann verliert es augenblicklich seine Macht über uns.

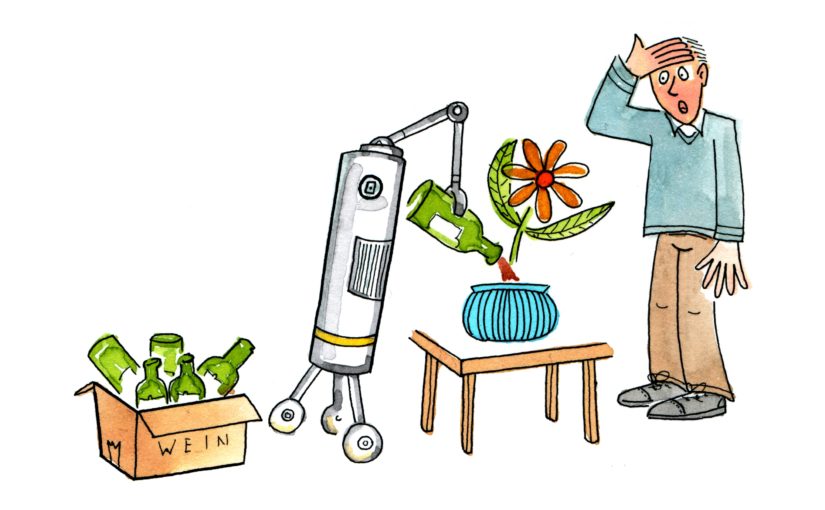

Die Frage ist, welche Absichten mit einem Werkzeug verfolgt werden. Ein Hammer ist einfach ein Hammer: Man kann damit Nägel einschlagen und etwas bauen oder einem Menschen den Schädel einschlagen.

Aus meiner Sicht braucht es für KI strikte, gesellschaftlich anerkannte Regeln. Aber die Politik hinkt der technologischen Entwicklung um Jahre hinterher…